“围栏”时代,

AIAI穿越治理与能源的穿越治理与能源的“迷宫”

IT时报记者沈毅斌毛宇

79年前,一道刺眼的白光闪耀天际,照亮整个阿拉莫戈多沙漠;炽热的火球迅速膨胀,瞬间吞噬掉周围的一切,一朵千米高的蘑菇云拔地而起;数秒过后,巨大的冲击伴随震耳欲聋的声音冲向两百英里外的洛斯阿拉莫斯实验室……这一刻人类掌握了“太阳”的力量,奥本海默也成为真正的“死神”。

79年后,人类再次走到“十字路口”,名为“人工智能”的路牌分别指向“发展”与“毁灭”两条道路。

在AI技术的飞速发展中,我们仿佛身处一个充满无限可能的“围栏”之内。然而,这个“围栏”并非界限的阻碍,而是对AI发展与应用进行规范与治理的框架。

随着AI在战争等领域的应用,人类必须确保其健康发展并服务于人类的福祉。全球范围内,各国已经开始形成共识,共同制定AI治理的原则和宣言。

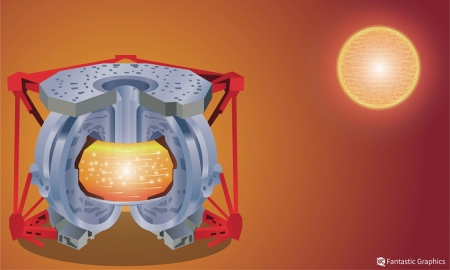

同时,AI对算力中心能源消耗的挑战也逐渐显现。我们必须构建一个更加高效、环保的算力中心“围栏”,以实现AI产业的可持续发展。

AI治理:发展面临“奥本海默”时刻随着Chat-GPT、Sora等大模型走进大众视野,在提高工作效率同时,也让人们感受到伦理问题、版权归属、隐私泄露等前所未有的风险;俄乌战争、巴以冲突打开了AI的“潘多拉魔盒”,人类战争开始向数据、算力、系统等技术方向转变,变成智能化战争,而用于战争的AI被称为是自火药、核能之后的第三次军事革命。当人工智能被用于战争的那一刻,就意味着“杀人机器”启动,AI这把“双刃剑”的“剑鞘”究竟要如何打造,是如今世界各国和全人类需要构建的可持续未来的“围栏”。

AI“战争机器”被启动

两朵蘑菇云在广岛和长崎拔地而起之时,“原子弹之父”奥本海默的内心无比煎熬,尽管是用于对侵略者的打击,但这足以毁灭世界的力量,也让他成为名副其实的“死神”。“作为科学家,我们不能逃避对这场‘重大危机’的责任。因为这种量级上的变化不仅改变了战争的性质,国与国之间的关系也需要从精神、法律、观念和情感上‘彻底’改变。”《奥本海默传》一书记录了奥本海默当时的观点。

当科技发展,尤其是在战争武器领域达到一个关键节点时,人们会像奥本海默一样意识到自己的行为将带来不可预测的灾难性后果,便陷入道德伦理谴责的困境中,这就是“奥本海默时刻”。

时至今日,以人工智能为核心打造的自主武器系统,让人类社会发展再次迎来“奥本海默时刻”。

据5月5日央视《世界周刊》报道,曾在乌克兰战场专门负责AI作战测试的美国第18空降军中将多纳休表示,乌克兰战场已成为美军“AI武器实验室”;《纽约时报》披露,由五角大楼主导的“梅文计划”正在乌克兰战场得到快速训练和完善。其中,“梅文智能系统”能够将卫星、雷达、红外设备甚至社交媒体上的影像处理后汇总到一块屏幕上,帮助接入该系统的人员快速识别出打击目标。

对于人工智能武器化的风险,香港中文大学(深圳)前海国际事务研究院副研究员梅阳和香港中文大学(深圳)前海国际事务研究院战略与安全研究团队学生助理朋措文德联合发布的《从巴以冲突平民死伤看AI的负责任军事应用》认为,人工智能在军事上的用途应该遵循透明度、人类控制、目标区则、紧急刹车、可控技术转让、国际军控合作和定期评估七项原则。

国家新一代人工智能治理专业委员会主任、清华大学苏世民书院院长薛澜在参加访谈节目时表示,在人工智能军事领域的应用,中美作为人工智能第一梯队的国家还存在差异。中国此前曾向联合国提出人类社会禁止开发和应用大规模自主性杀伤性武器,但并没有得到包括美国在内的主要国家支持。对此,一方面需要运用联合国机制、双边机制等进行探讨治理,另一方面则利用各国的共同利益,如防范极端组织滥用AI等,形成治理方式。

比“奥本海默时刻”更复杂

“在人类发展历史中,将先进技术用于战争并不是第一次,就像恩格斯在《反杜林论》中说,人类以什么样的方式生产,就会以什么样的方式作战。”清华大学战略与安全研究中心副主任肖茜告诉《IT时报》记者,当下AI的发展与治理,和奥本海默当时面临的情况不太一样,AI会更加复杂。核武器技术始终掌握在世界上少部分国家手中,拥有较高的技术门槛。而AI是一项开源的技术,上至国家、企业,下至用户个人,都能应用甚至开发AI技术,门槛也相对较低。

也正是因为这种特性,AI治理面临诸多复杂难题,最重要的便是平衡科技创新和风险管理之间的关系。肖茜表示,规则、宣言等出台往往会稍落后于技术,因此在出台政策前需要收集社会各界利益相关方的意见,形成暂行办法,既能给人工智能留出充足的发展空间,也能形成一套大框架约束AI。在肖茜看来,这样的灵活治理对中国而言有着体制优势,同时也是各国治理AI的有效方式之一。

在近期中法两国对人工智能方面达成的共识中也提到,人工智能治理模式,既应顾及技术不断快速发展所需的灵活性,同时应对个人数据、人工智能用户的权利以及作品被人工智能使用的用户权利提供必要保护。

此外,伦理、社会、产业等人工智能渗透的各行各业同样需要进行有效治理。“从大方向看,各国对于AI治理的原则都是向着人类社会的一致性,但一些详细的规则、操作模式等,由于各国差异难以统一。”肖茜告诉《IT时报》记者,单一层面在国际社会中达成共识是有可能的,但想要多层面都达成共识,还需要加强各国之间的合作。

AI治理需要全球参与

5月5日至7日,在2023年《中法联合声明》达成共识的基础上,中法两国尤其针对人工智能方面达成共识,其中明确表示人工智能发展中遇到的机遇、风险和挑战本质上是全球性的,加强国际合作具有非常重要的意义。同时,两国主张人工智能必须为所有人提供包容性接入,在线提供可访问、可视和可发现的内容,尊重多种语言和文化多样性,包括在多边框架内。

2023年,中国先后发布《生成式人工智能服务管理暂行办法》《全球人工智能治理倡议》;美国发布首个生成式人工智能监管规定;首届人工智能安全峰会上,中国、美国、英国等28个国家和欧盟共同签署《布莱奇利宣言》;2024年3月13日,欧盟批准的《人工智能法案》是世界上迄今为止最全面的人工智能立法,为人工智能系统开发和技术应用确立了清晰的边界。尽管有关人工智能治理的倡议、宣言逐渐增多,但对于人工智能治理的具体准则,国际社会仍然没有达成一致共识。

“我们参与国际会议和论坛时,有对是否成立一个类似国际原子能机构的组织来统一治理人工智能进行过讨论,但目前还处于初期。”肖茜表示,大国引领将是人工智能形成统一治理的关键,中美两国作为人工智能第一梯队国家尤为重要。但由于意识形态不同,目前,人工智能达成共识的大多还是小团体,如美国与G20集团、欧盟等组织,中国呼吁的则是在联合国机制下的全球性合作。